VII ежегодная

SEO Conference 2016

29-30 сентября 2016 года в Иннополисе (Казань) прошла VII ежегодная конференция SEO Conference 2016. Конференция проходила в 3 потока: SEO, Digital, Mobile. Мероприятие посетил наш ведущий специалист департамента интернет-маркетинга Дмитрий Мрачковский и подготовил для вас обзор наиболее интересных докладов.

Для SEO-конференций уже стало своеобразной традицией делать как минимум один секретный доклад — его тема (а иногда — и имя спикера) держится в тайне от участников до последнего момента. Зачастую, такие доклады открывают конференцию. Поэтому и мы не будем отступать от этого негласного правила и начнем свой обзор именно с такого доклада.

Поведенческие факторы 7.0

или SEOPickup

Стало неожиданностью, когда на сцене появился Роман Морозов из Userator — многие восприняли это скептически, т.к. поняли, что сейчас он будет в очередной раз пиарить свой сервис по накрутке поведенческих факторов c новым подходом. Эволюцию накрутки ПФ можно представить в следующем виде из 6 ступеней: боты, живые люди, усиление ссылок, социальные факторы, мобильные поведенческие факторы, MoneyCaptcha. Все эти способы работают всего на 3-5%, по оценкам некоторых оптимизаторов — всего на 1-2%, причем только в долгосрочной перспективе. И кажется, что сложно придумать здесь что-то новое, что даст видимый результат в короткий срок. Но с 7-ой версией Роман смог нас удивить.

Идея данного способа в следующем:

- Открытие сайта поисковой системы. Подойти к незнакомому человеку и попросить открыть сайт yandex.ru через его мобильный телефон/планшет/ноутбук.

- Ввод поискового запроса. В строку поиска ввести «купить xxx в москве» и нажать кнопку «Найти».

- Поиск продвигаемого сайта. Найти нужный сайт в выдаче поисковой системы.

- Переход на сайт. Перейти на продвигаемый сайт (по предложенной странице входа).

- Переход на другие страницы. Пролистать минимум 3 страницы. Попутно попросить незнакомого человека оценить качество сайта.

Весь процесс записывается на видео, которое является доказательством выполнения задания.

Среди преимуществ данного способа перед другими методами накрутки можно выделить:

- Результат виден в течение недели — метод влияет на факторы ранжирования, использующиеся в режиме real-time, т.е. не нужно ждать «апдейтов» различных типов.

- Влияние на выдачу происходит после «пикапа» уже 15 человек.

- Неестественность действий отследить сложно: доля мобильного трафика растет, корреляция «пикапа» с офлайн-рекламой, паттерны поведения людей все более размытые и устройства в семье все чаще становятся общими (из-за всего этого технология Яндекса по определению пользовательских скриптов поведения Крипта становится малоэффективна).

- Как бонус — мини-аудит сайта.

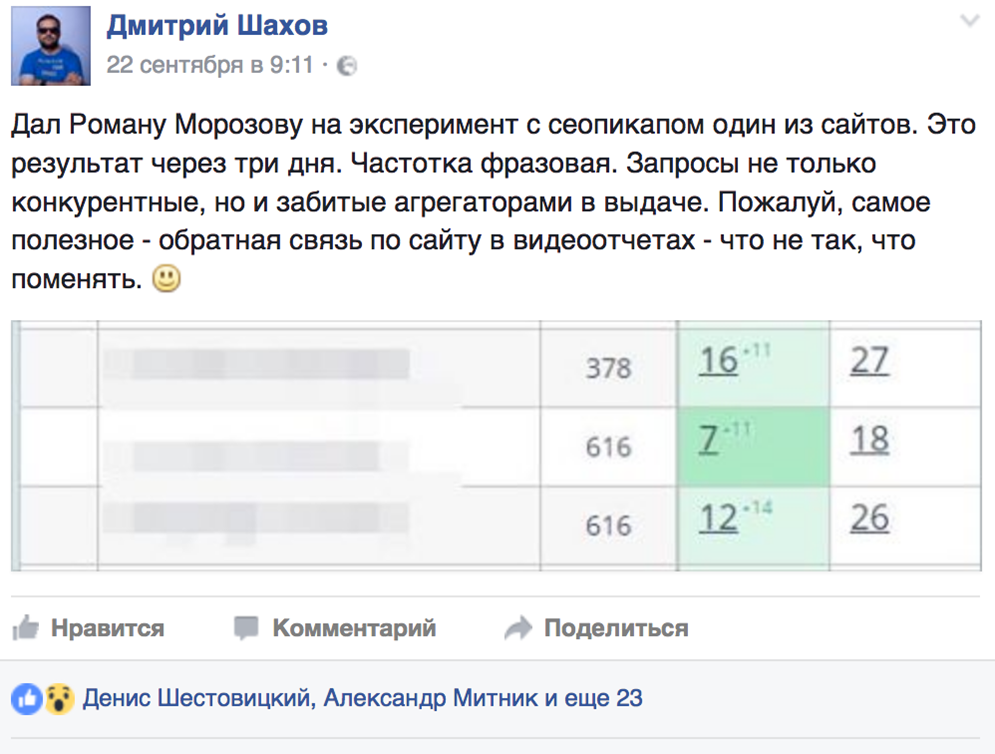

Для тестирования данного способа Роман выбрал несколько известных SEO-оптимизаторов. В качестве примера эффективной работы метода — отзыв Дмитрия Шахова.

Как конкуренты могут

повредить вашему SEO

Дмитрий Шахов рассказал о возможных проблемах на сайте, которые конкуренты могут использовать против вас самих.

Прежде, чем думать о том, как могут навредить конкуренты, стоит проконтролировать все, что зависит непосредственно от вас самих, т.к. большинство ошибок совершается все же по вине владельца/оптимизатора/команды сайта. Среди них могут быть:

- закрытие сайта в disallow или в мета;

- непродленный вовремя хостинга;

- удаление трафиковых страниц (в том числе изменение URL-адреса без настройки 301-редиректа);

- изменение адресной структуры;

- агрессивная перелинковка;

- изменение контента на посадочных страницах;

- случайное создание дублей;

- и многое-многое другое...

Если себя проконтролировали и исправили все ошибки, но у сайта наблюдаются проблемы с ранжированием и/или индексацией, то есть вероятность, что это происки конкурентов.

Влияние на индексацию сайта

Если на вашем сайте можно найти какую-либо аномалию, позволяющую сгенерировать огромное число однотипных (одинаковых) страниц, отдающих код ответа 200, то конкуренты могут использовать это в своих целях. Обычно аномалия выглядит как незакрытый от индексации произвольный (или необходимый для функционала сайта) GET-параметр, изменение значения которого не приводит к изменению контента страницы (или к его исчезновению вовсе, главное — что страница отдает корректный код ответа). Масштабируя такие аномалии и отправляя их на индексацию через различные бот-сети, конкуренты забивают краулинговые лимиты (бюджеты) для вашего сайта в поисковых системах — поисковые роботы пытаются проиндексировать огромное число несуществующих страниц, откладывая индексацию других страниц сайта (в том числе и целевых). Все это может привести к обвалу индекса посадочных страниц, а вслед за этим — снижению позиций и трафика.

Другой способ влияния на индекс вашего сайта извне — подловить момент, когда истечет время аренды хостинга или домена. Пока сайт будет недоступен, конкурент может отправить его на переиндексацию в поисковые системы, которые увидят, что все страницы отдают некорректный код ответа.

Способ борьбы с этим — верно настраивать индексацию сайта, проверять панель вебмастера на наличие резкого роста загруженных страниц и, конечно же, вовремя продлять хостинг и домен.

Изменение контента

Актуально для сайтов, имеющих возможность размещения UGC (User Generated Content): блоги, форумы, порталы, сайты с социальными модулями и модулями комментариев. Есть несколько способов повлиять на контента чужого сайта:

- Смещение текстовой релевантности. Можно разместить хороший, качественный комментарий/пост, но он будет «накачан» ключевыми словами, не относящимися непосредственно к тематике страницы. В итоге, текстовая релевантность такой страницы будет размыта в глазах поисковых систем и она может ранжироваться хуже.

- «Раздуть» страницу. Страницы объемом свыше 10Мб (только верстка, без учета картинок, видео и других медиа-данных) не индексируются Яндексом. Способ проблематичный — не так легко добавить столько контента на страницу, но это возможно.

- Размещение противозаконного контента. После размещения подобного контента ускоряется реиндексация страницы и подается жалоба в РКН. Это довольно подлый способ «завалить» конкурента, но некоторые используют и его.

Способ борьбы с такими методами прост — следить за новым UGC на сайте, анализировать и чистить некачественный контент.

Внешние ссылки

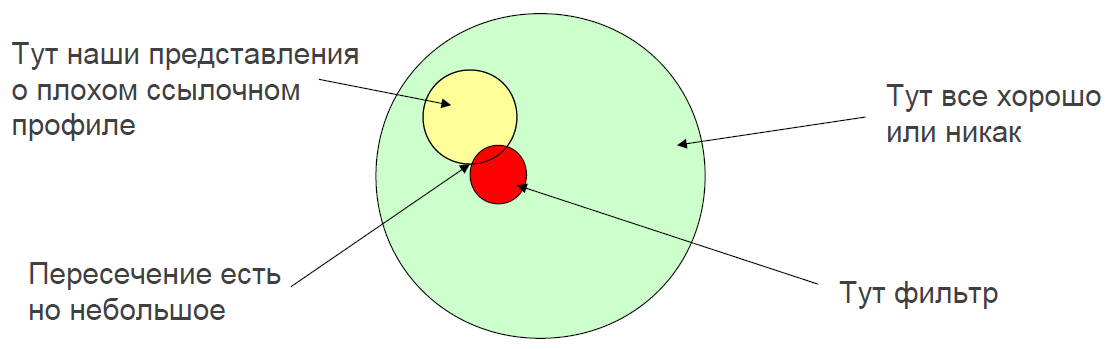

Самый банальный и очевидный способ — закупить на сайт конкурента низкокачественных ссылок, да побольше. Но все не так просто — не все плохие ссылки могут навредить сайту:

Как видно, наши представления о плохих ссылках, способных негативно повлиять на сайт, и реальное множество таких ссылок имеют небольшое пересечение. К тому же, резкий рост ссылочного хорошо заметен поисковым системам и они его могут полностью проигнорировать. Единственная возможность повлиять в этом направлении — монотонная постоянная закупка низкокачественных ссылок, без резких скачков, с имитацией естественной закупки. Еще большую опасность будут представлять подобные ссылки с нерелевантными анкорами, анкорами adult-тематики, противозаконным контентом. Также в последнее время стало популярно писать владельцам площадок, на которых размещены качественные вечные ссылки, и просить снять их — вебмастера не всегда проверяют принадлежность лица, просящего снять ссылки, к сайту, на который они ведут, и делают это — бесплатно или за дополнительную плату.

Как итог — необходимо постоянно анализировать внешнюю ссылочную массу сайта, обращать внимание на системный рост некачественных ссылок. Такие ссылки можно добавлять в Disavow Tool — инструмент вебмастера Google. В случае Яндекса, единственный вариант — обращаться в техподдержку и надеяться на своевременную правильную реакцию.

Другие способы

Выше приведены наиболее популярные методы воздействия на сайт конкурентами, но с которыми владелец сайта может бороться при постоянном анализе сайта. Есть еще несколько способов, но чтобы они дали хоть сколько-то значимый результат, ими нужно заниматься постоянно, системно, в течение нескольких месяцев.

- Накрутка поведенческих факторов. Очень долгий способ с маленьким шансом на успех. Здесь можно выделить: рефспам (автоматизация попадания сайта в статистику других сайтов) и нецелевой трафик (попадание на сайт по ссылкам с нерелевантными или противозаконными анкорами или со страниц сайтов таких тематик). Доля такого трафика должна быть значимой к общему трафику сайта, чего достаточно сложно добиться.

- Свойства домена. Можно попытаться склеить какой-либо плохой сайт с сайтом конкурента и добиться наложения санкций, либо создать целую сетку сайтов с похожими к конкуренту свойствами (шаблон, контент, адрес, телефон и др.), после чего «утопить» всю сеть под каким-либо фильтром в надежде, что сайт конкурента также «попадет под раздачу».

- Дублирование контента. Здесь можно дублировать как отдельные материалы конкурента, так и весь сайт целиком. Таким способом можно добиться выпадения конкурента из топа, склейки по сниппетам или перехвата части трафика, но добиться смены авторства — трудно.

Профилактика от таких происков конкурентов одна — системный анализ всех внешних факторов, способных повлиять на ранжирование вашего сайта. Если были замечены нерелевантные ссылки, трафик, появление сайтов-дубликатов или отдельных материалов, то нужно обращаться в техподдержку поисковых систем, предупреждая возможные последствия.

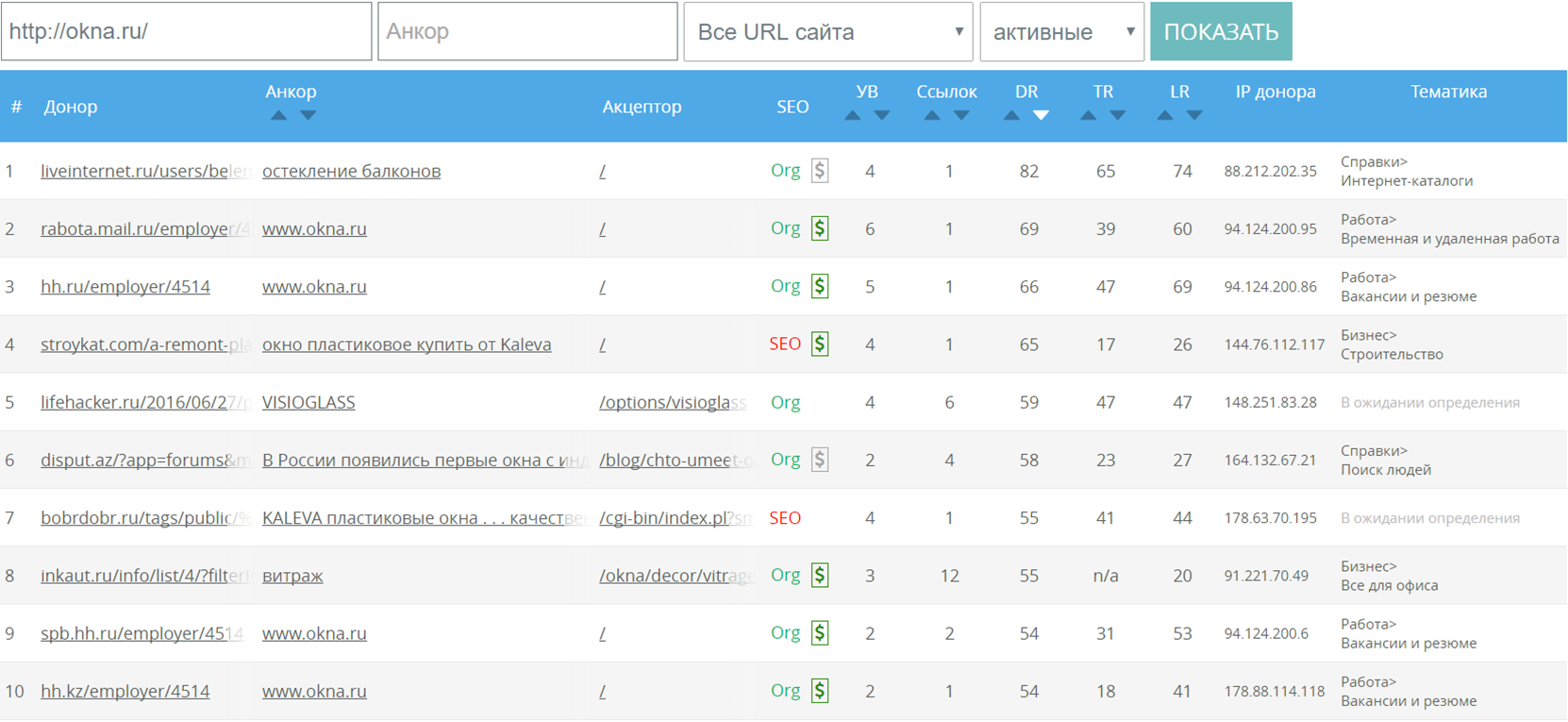

Ссылки в 2016 году

На SEO Conference 2016 было несколько докладчиков, затронувших тему ссылок, традиционно обсуждаемых на каждой конференции — среди них Николай Хиврин, Сергей Юрков, Руслан Байбеков и другие. Представляем вашему вниманию выжимку рекомендаций по работе с ссылками в текущих условиях.

Проблемы ссылочных доноров

Из года в год проблемы ссылочных доноров не меняются: размещение плохого/неуникального контента, плохой внешний ссылочный профиль, спам в анкорах исходящих ссылок, слишком большое количество исходящих ссылок, наличие блоков рекламных сетей (за исключением Яндекс.Директ и Google AdSense), малое количество или вовсе отсутствие трафика — т.е. все то, что не позволяет поисковым системам признать данный сайт хорошим. Подобных плохих доноров становится только больше, что делает работу со ссылками более сложной, на поиск хороших доноров тратится все больше времени.

При работе со ссылками важно учитывать следующие моменты:

- Значительная доля SEO-ссылок фильтруется Яндексом и не вносит/вносит незначительный вклад в ранжирование («Непот-фильтр»).

- Находим рабочие «естественные» ссылки по ссылочным профилям конкурентов и составляем white-листа сайтов доноров.

- Учитываем количество SEO-ссылок в ссылочном профиле для избегания Минусинска.

Наращивание ссылок

в условиях Минусинска

Для того чтобы избежать Минусинска, следует принять во внимание следующие советы:

- Работа в безопасных диапазонах доли SEO-ссылок.

- Покупка нескольких ссылок с одного донора.

- Поиск естественных ссылок.

- Отслеживание количества SEO-ссылок на этапе прихода проекта на продвижение.

- Ориентир на количество SEO-ссылок у топовых конкурентов.

- Арендные ссылки в приоритете перед вечными.

- Чистка некачественных вечных ссылок в качестве профилактики для возможности увеличения количества качественных SEO-ссылок.

Список советов почти традиционный, не меняющийся из года в год. Почти — т.к. есть пара новшеств:

- В течение последних лет рекомендовали покупать именно вечные ссылки, а не арендные. Но с приходом Минусинска появилась проблема невозможности своевременно избавиться от некачественных вечных ссылок: вебмастера не выходили на связь или, наоборот, с радостью отвечали, но просили заплатить за снятие ссылки, а при переходе проекта от одной компании к другой возникали проблемы с подтверждением причастности к проекту — некоторые вебмастера просили подавать заявки на снятие только через биржу, где были заказаны ссылки. С арендными ссылками подобных проблем практически нет.

- Раньше была тенденция к наращиванию ссылок с уникальных доменов: один донор — одна ссылка. Теперь же для большей естественности и повышения качества ссылочного профиля можно проставлять несколько ссылок с одного действительно качественного донора.

Немаловажной проблемой является определение ссылок, которые Яндекс может посчитать SEO-ссылками — при превышении их допустимого количества, которое определяется для каждого сайта индивидуально, неизбежно последует наложение санкций. Компания Пиксель-Плюс поделилась исследованием по безопасному количеству SEO-ссылок на сайтах своих клиентов:

Если встала проблема определения типа ссылки, то на помощь может прийти сервис Megaindex с инструментом определения SEO-ссылок по различным параметрам:

Продвижение коммерческих запросов

Сергей Юрков в своем докладе «Продвижение сайтов в 2016 году: нюансы работы и нововведения» разобрал проблемы, про которые все знают, но которым порой не уделяется должного внимания. Он их разбил их на 4 категории: типы запросов, текстовая оптимизация, ссылочный профиль и пост-анализ. Большинство вопросов, так или иначе, представлены в других докладах, поэтому здесь мы вам расскажем о продвижении коммерческих запросов.

При продвижении коммерческих запросов необходимо учитывать 2 важных составляющих: во-первых, в ранжировании участвуют не только общие факторы, но также и коммерческие, а во-вторых, продвигаемая страница должна классифицироваться как коммерческая.

Классификация страницы как коммерческой

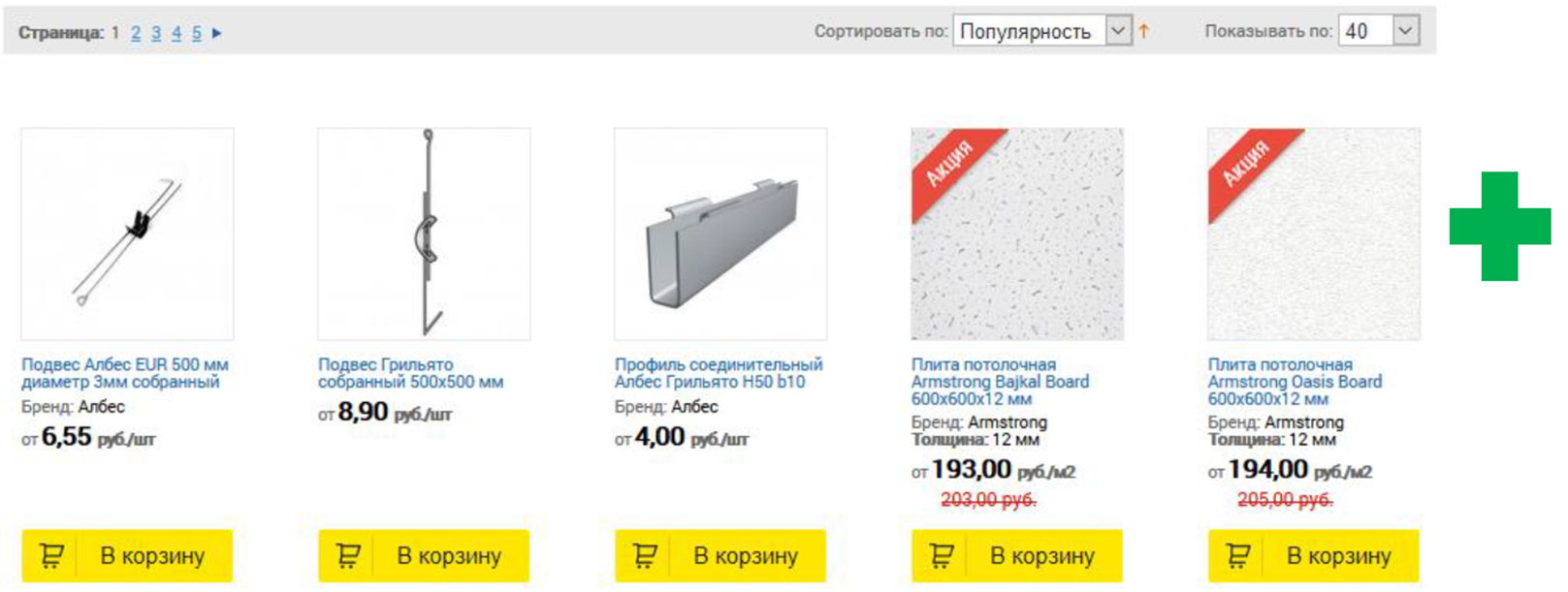

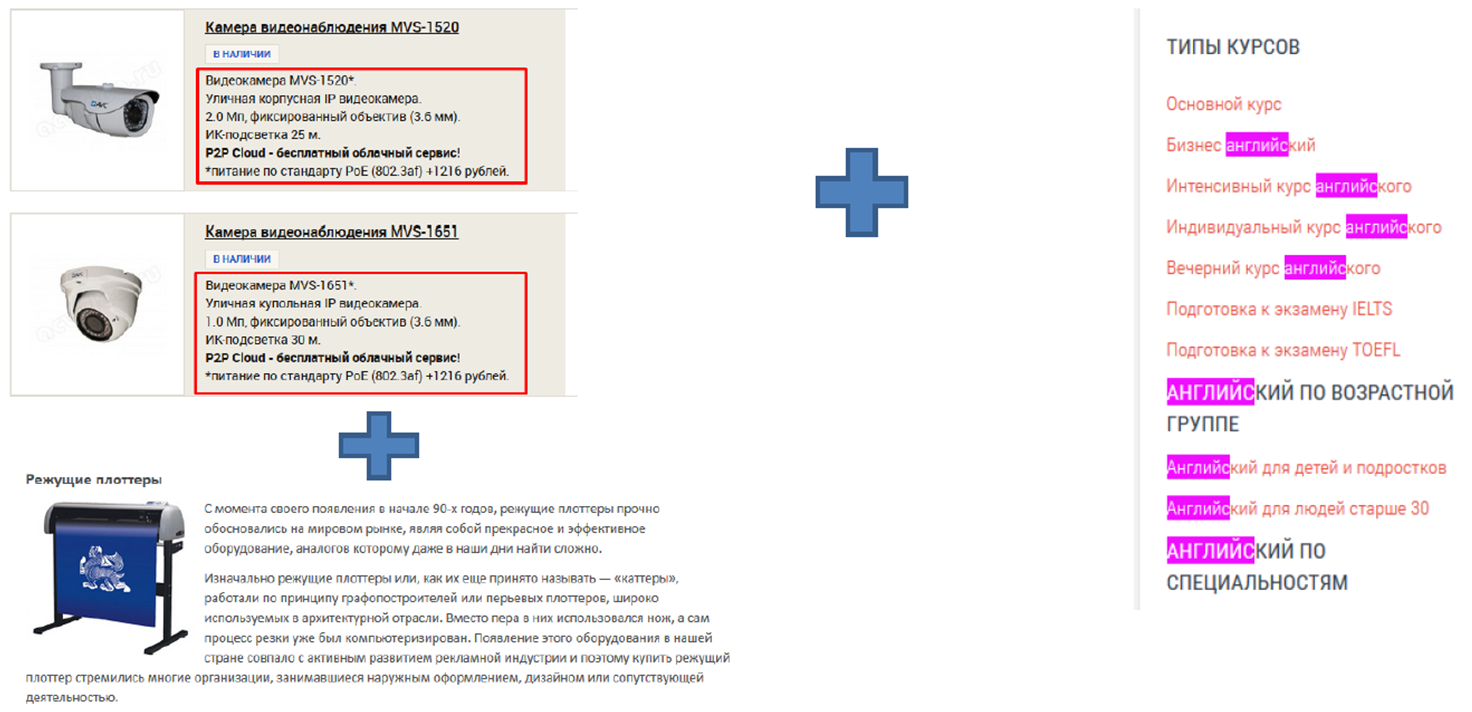

Тип продвигаемой страницы. Сравним целевые страницы двух сайтов, продвигающихся по запросу [подвесные потолки]. Очевидно, что для клиента будет полезнее увидеть страницу с каталогом товаров и ценами, чем страницу с огромным количеством текста и ссылками на прайс-листы в нескольких отдельных файлах.

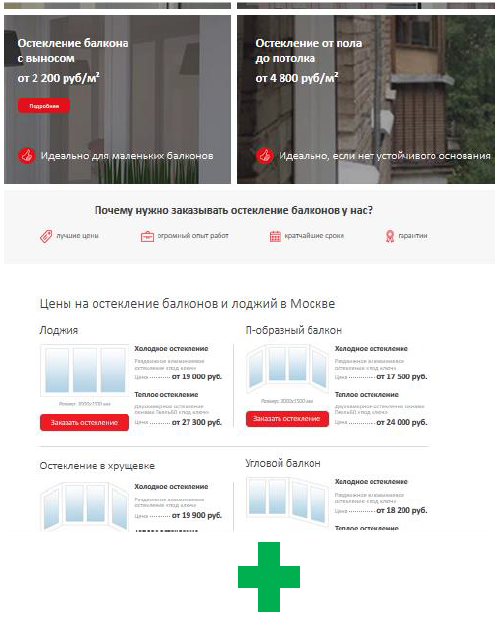

Если у вас сайт услуг, например, [отделка балконов], то также предлагайте своим пользователям не сухую информацию, которую можно даже классифицировать как «сделай сам», а в наиболее выгодном свете представляя свое предложение:

Текстовая оптимизация с учетом коммерческих факторов. Уже давно пора отказаться от идеи, что контент на странице — это лишь блок текста под ассортиментом товара. Оптимизированный текст должен находиться в различных частях контента: превью товаров, меню, различные отрезки текста с анонсами услуг и т.д., главное — чтобы в этих участках пользователь находил ответ на свой вопрос.

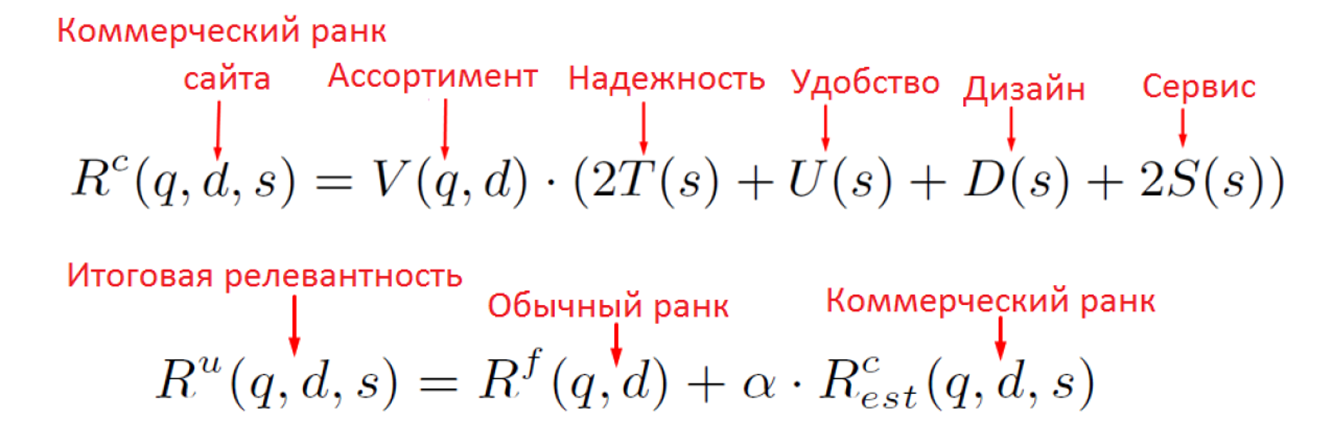

Коммерческое ранжирование

Формулу коммерческого ранжирования можно представить в следующем виде:

Как видно, в определении коммерческого ранга роль играют 5 составляющих: ассортимент, надежность сайта, удобство, дизайн, предлагаемый сервис. Все они зависят от одного или нескольких аргументов: запрос пользователя (q — query), целевой страницы (d — document) и качества сайта в целом (s — site). Коммерческое ранжирование имеет несколько отличительных черт:

- направлено только на релевантные документы с сайта, а не на все имеющиеся;

- оценивается для сайта в целом;

- плохие поведенческие факторы могут свидетельствовать о низком уровне коммерческих факторах.

Разберем на примерах, как добиться высоких показателей в коммерческом ранжировании.

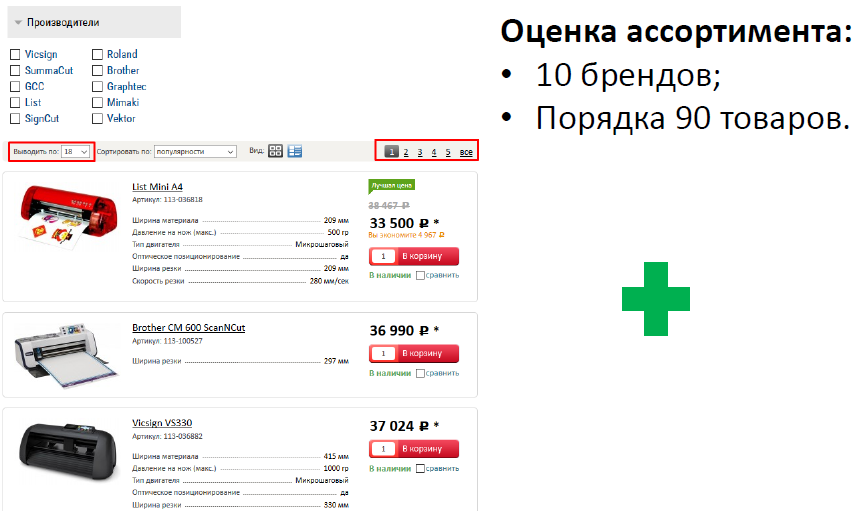

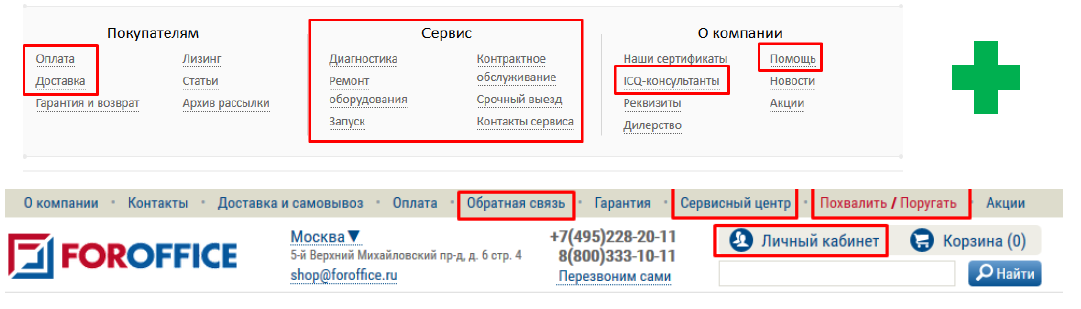

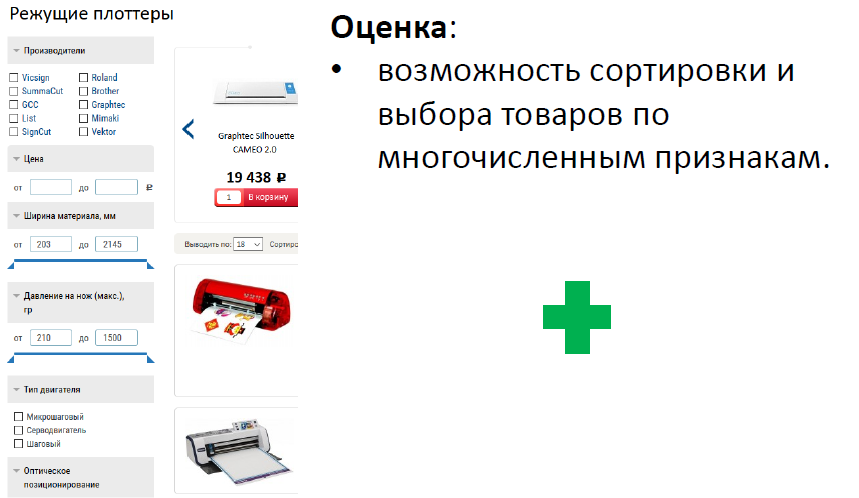

Ассортимент. Чем больше выбор из различных товаров и брендов — тем дольше посетитель задержится на вашем сайте, формируя качественные поведенческие факторы, и что-то выберет и купит именно у вас. Сравните ассортимент двух интернет-магазинов по запросу [режущий плоттер купить], думаю, выбор очевиден:

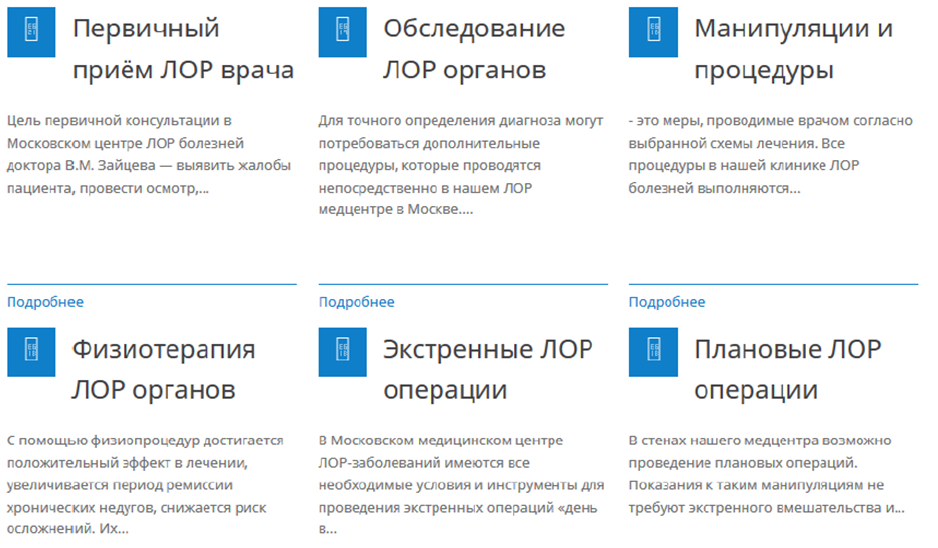

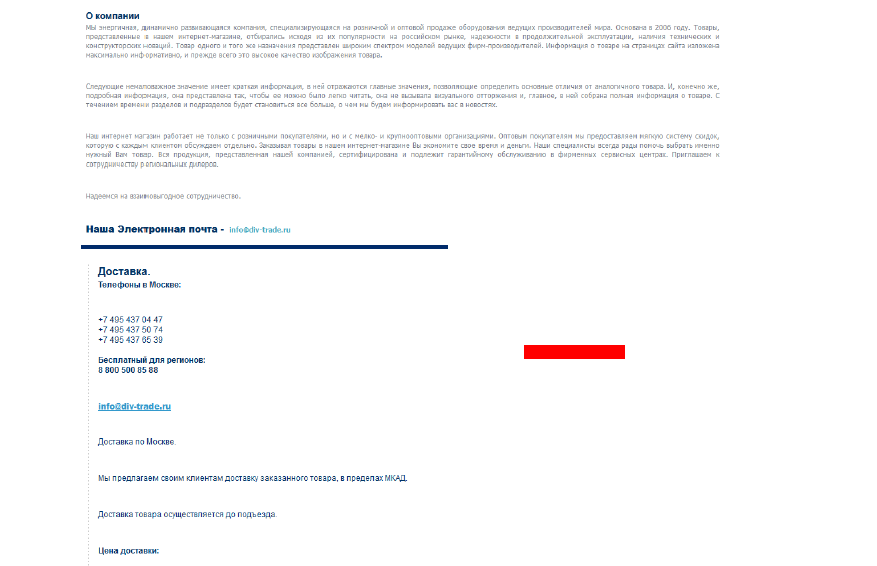

Надежность. Пользователь должен вам поверить, поэтому необходимо представить всю возможную информацию и компании: максимально полную контактную информацию, информацию о представительствах, информация о гарантии, доставке и возврата товара, различные сертификаты, фото сотрудников, фото фасада здания со входом в офис и т.д., другими словами, все, чтобы у посетителя сайта сложилось четкое ощущение, что вы — надежная компания, которой можно доверять. Сухой текст с рассказом о создании компании, общими фразами, не подкрепленные конкретными цифрами, скудная контактная информация — все это лишь оттолкнет посетителя.

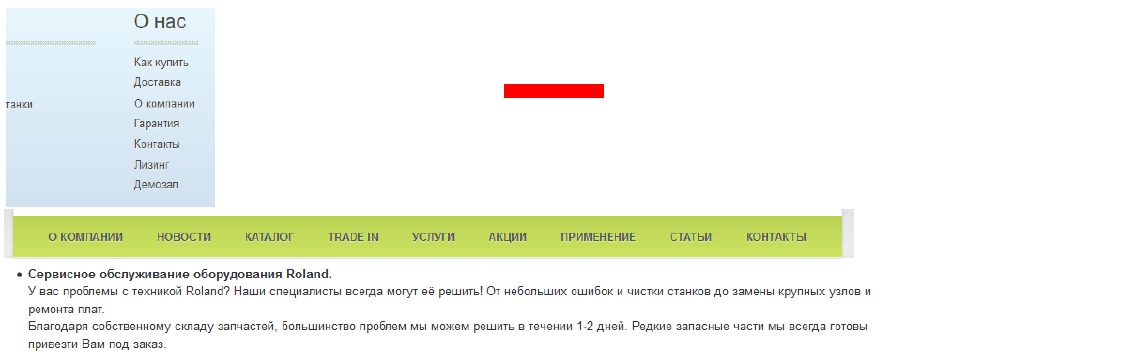

Качество сервиса. У посетителей сайта не должно возникать проблем с поиском ответа на вопрос, как связаться с вашей службой поддержки, какие услуги могут быть оказаны, в каком объеме и как быстро — ссылки/кнопки на различные способы связи и разделы с сервисной информацией должны быть на видном месте.

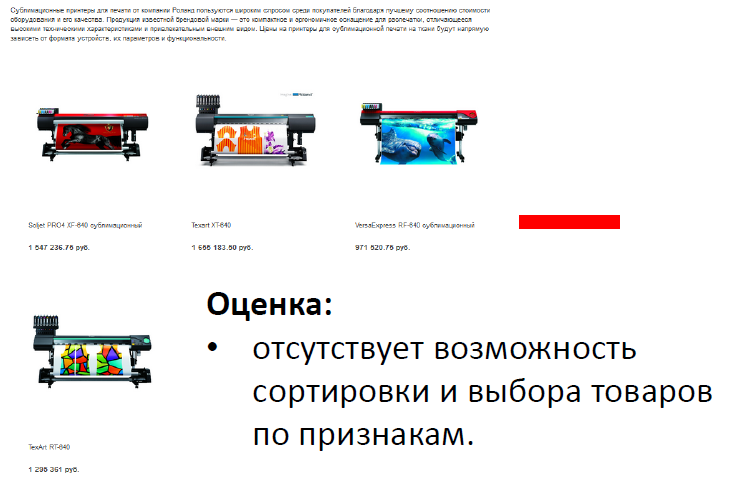

Удобство. Если у вас, например, интернет-магазин, то для удобства пользователей необходимо сделать возможность различных способов сортировки товаров и фильтрации по важным параметрам — без подобных функциональных решений потенциальный клиент может просто не сориентироваться в вашем ассортименте, особенно, он довольно обширный, и покинуть сайт.

Автоматическая

классификация запросов

Доклад представил Алексей Чекушин — основатель сервиса Just-magic.org, помогающего автоматизировать рутинные SEO-задачи. Обычно, доклады Алексея довольно технические, и этот не стал исключением.

Для чего же необходимо знать различные типы классификации запросов? Ответ прост — в зависимости от типа запроса, для него выстраиваются различные стратегии продвижения (а по некоторым типам запросов в принципе не может быть возможности достижения ТОП-1). Классифицировать можно по различным признакам, среди которых:

- витальность запроса (т.е. можно ли его однозначно связать с конкретной компанией/брендом/сайтом, еще их называют брендовыми или навигационными запросами);

- доля главных страниц в выдаче по запросу;

- геозависимость;

- коммерческость;

- тематика запроса.

С витальными запросами все просто — если можно однозначно соотнести запрос с сайтом, к которому он относится, то запрос является витальным и с вероятностью 99,99% его ничто не подвинет с первого места в поисковой выдаче. Про коммерческие запросы мы уже говорили в прошлом докладе, а доля главных страниц в выдаче, геозависимость запроса и способы классификации таких запросов являются сугубо техническими вопросами, которыми мы не будем вас «грузить».

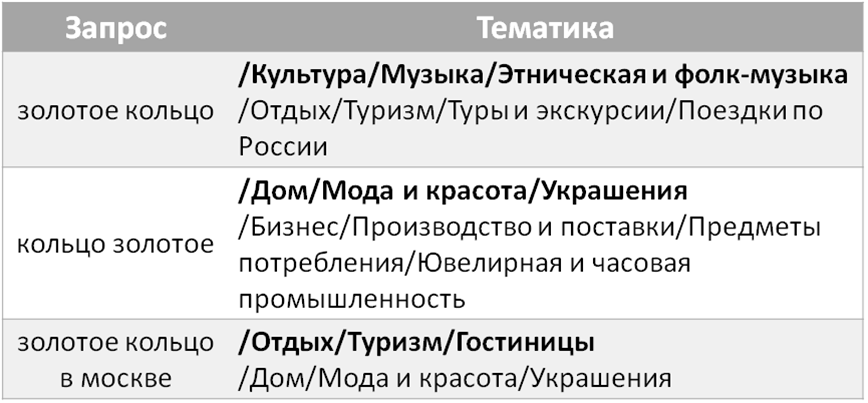

Наиболее интересным является вариант с определением тематики запроса. Например, сможете ли вы однозначно сказать, что именно хотел найти пользователь, введя следующие запросы: [золотое кольцо], [кольцо золотое], [золотое кольцо в москве]? Вариантов много: ювелирные украшения, туры по Золотому кольцу России, название газеты, название фольклорной группы и даже название гостиницы. И подобных запросов можно найти много — если по определению поисковой системы запрос будет принадлежать не к той тематике, к которой относится ваш сайт, то его будет проблематично продвинуть.

Для определения тематики запросов Алексей предложил использовать собственный алгоритм, а точнее — нейронную сеть, основанную на анализе сниппетов результатов поиска по запросу и обученную на классификации Яндекс.Каталога. Вот такие тематики определил инструмент для указанных в примере запросов:

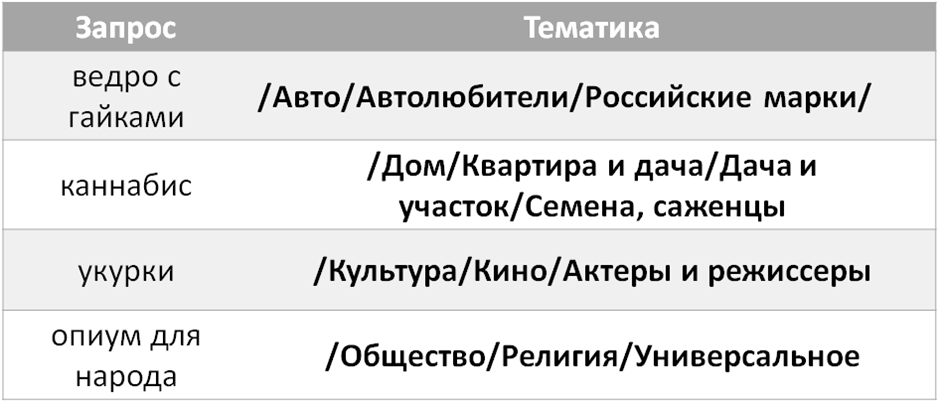

Главное достоинство этого алгоритма — он проводит анализ на основе данных, предоставляемых непосредственно поисковой системой, т.е. мы видим в какую тематику с высокой долей вероятности относит запрос сам Яндекс. А чтобы убедиться в этом, вот несколько интересных примеров работы алгоритма:

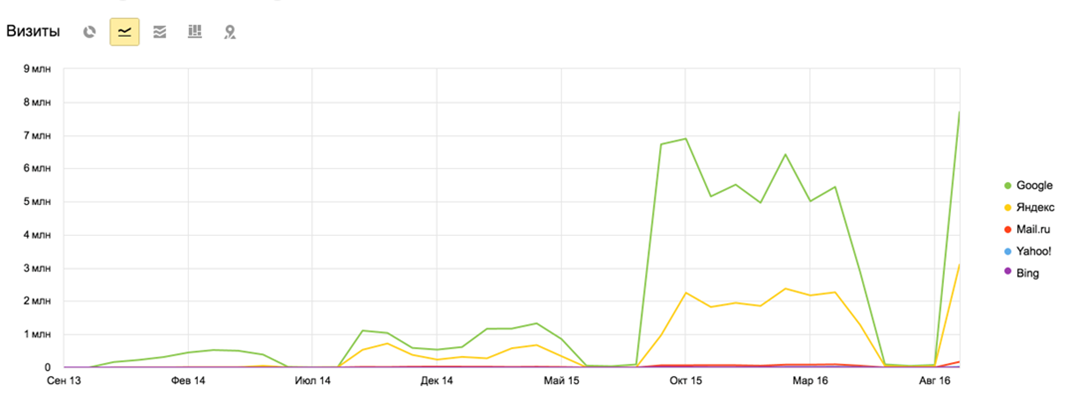

Прогнозная

аналитика в SEO

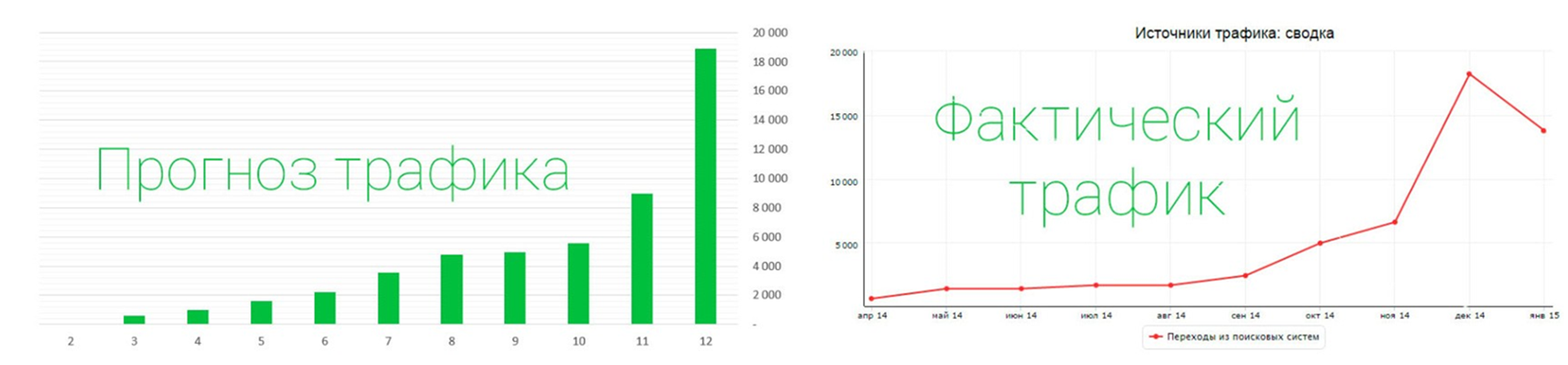

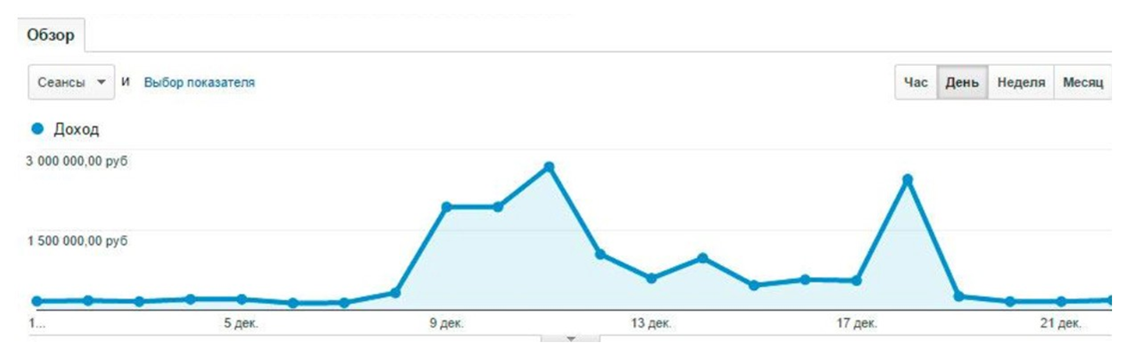

С одним из самых интересных докладов выступил Дмитрий Иванов из Укроп Медиа. Вопрос прогнозирования результатов SEO-продвижения — настоящая головная боль для многих агентств, т.к. клиенты хотят видеть, как будет развиваться их проект, причем не просто на словах с описанием этапов работ, а с конкретными цифрами и показателями позиций, трафика, количества заказов или даже прибылью к определенному моменту. Особенно важно это при закреплении KPI (ключевых показателей эффективности), за выполнение которых агентство отвечает материально. Чем же прогнозная аналитика может быть полезна в SEO и как ее использовать? Дмитрий предлагает двигаться в двух направлениях.

Прогнозирование трафика

Одна из первоочередных задач для тех, кто уделяет внимание прогнозированию результатов. Ее можно разбить на несколько этапов:

- Понять, какой спрос будет у запроса через год.

- Оценить сложность продвижения запроса — его конкурентность .

- Основываясь на текущих данных, спрогнозировать CTR через год.

- Спрогнозировать позицию с учетом продвижения и естественного роста, а также усилий конкурентов.

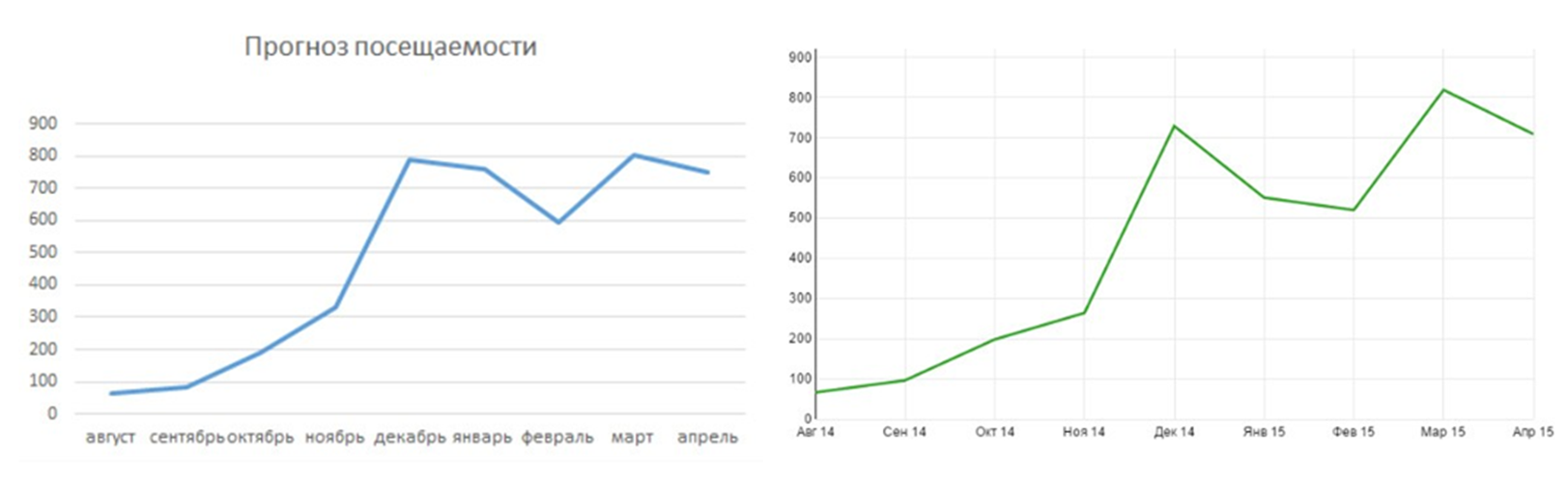

Ошибка на любом этапе вычислений даст погрешность в 10-20%. Задача сложная, но решаемая. Понимание того, что именно делать на каждом этапе, приходит с опытом. Дмитрий представил пару кейсов применения методики с прогнозируемыми значениями трафика и фактическими:

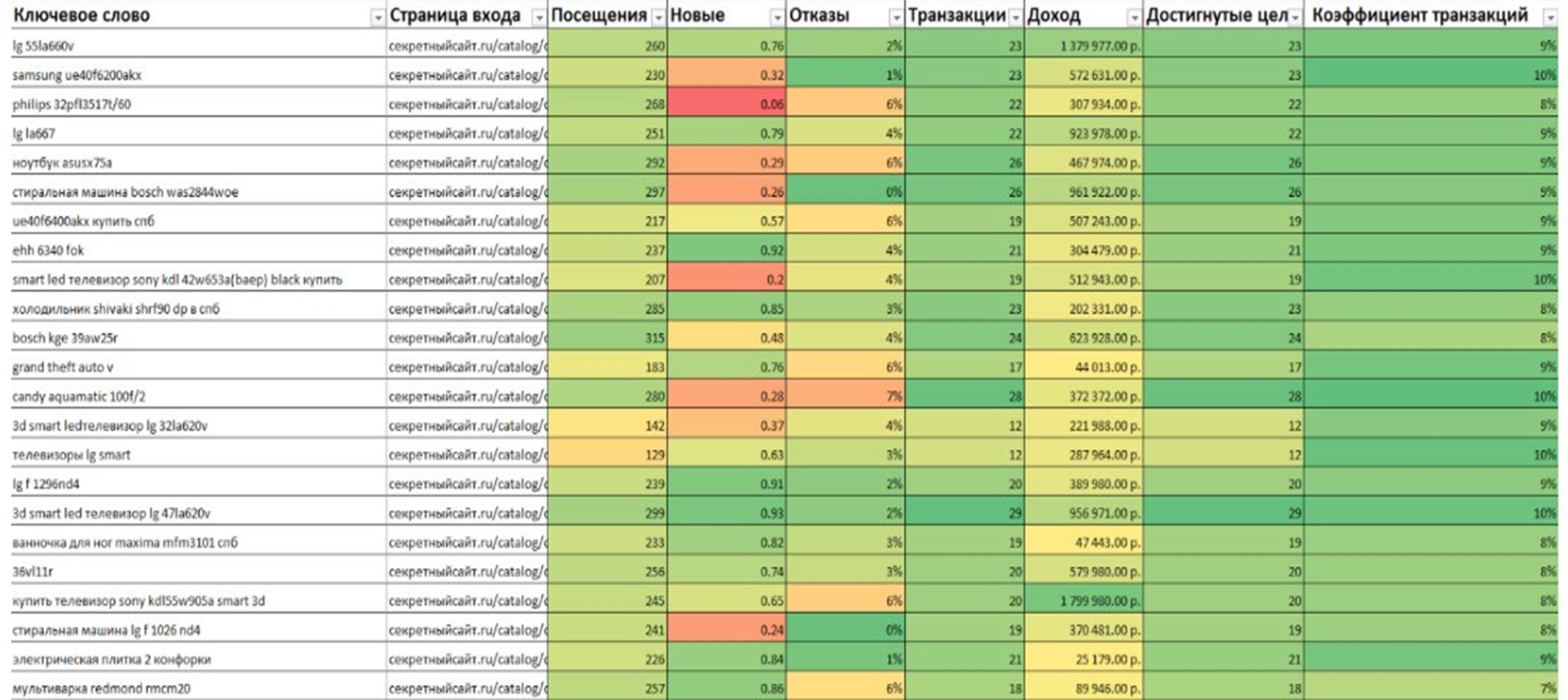

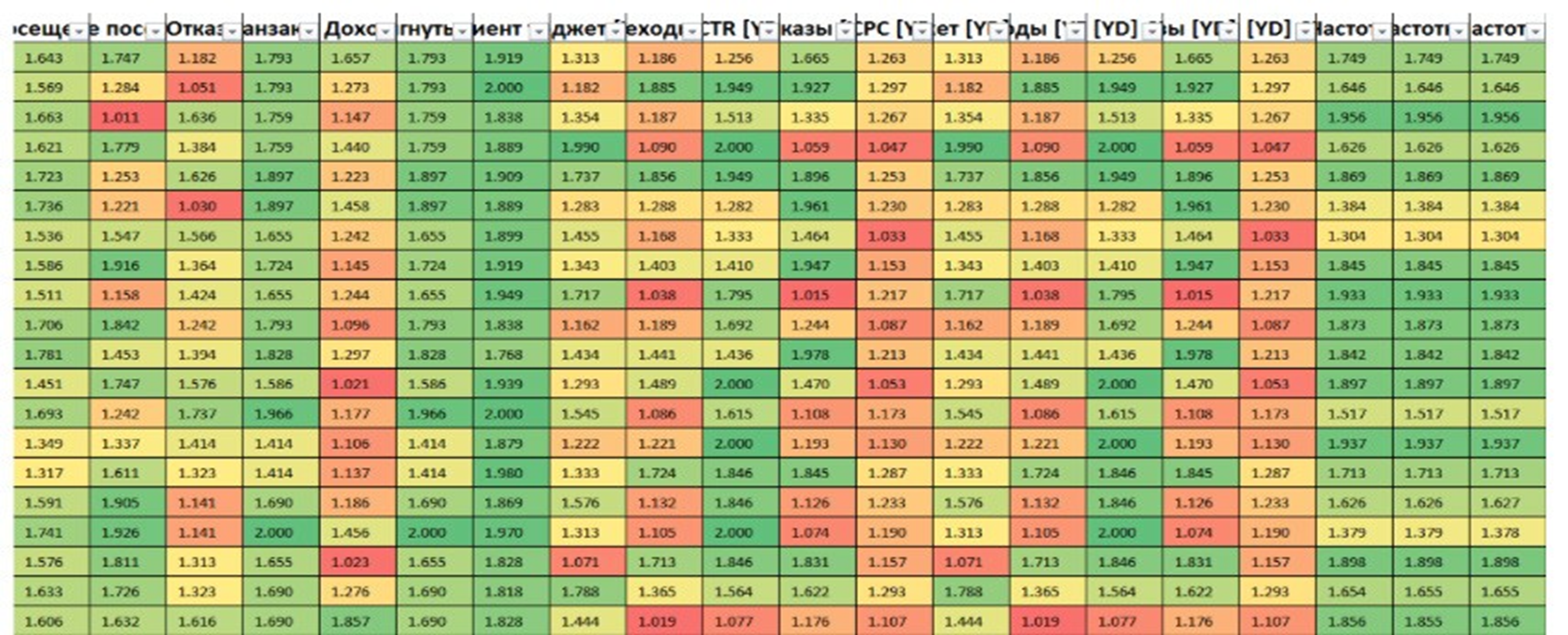

Прогноз эффективности посадочных страниц и товаров

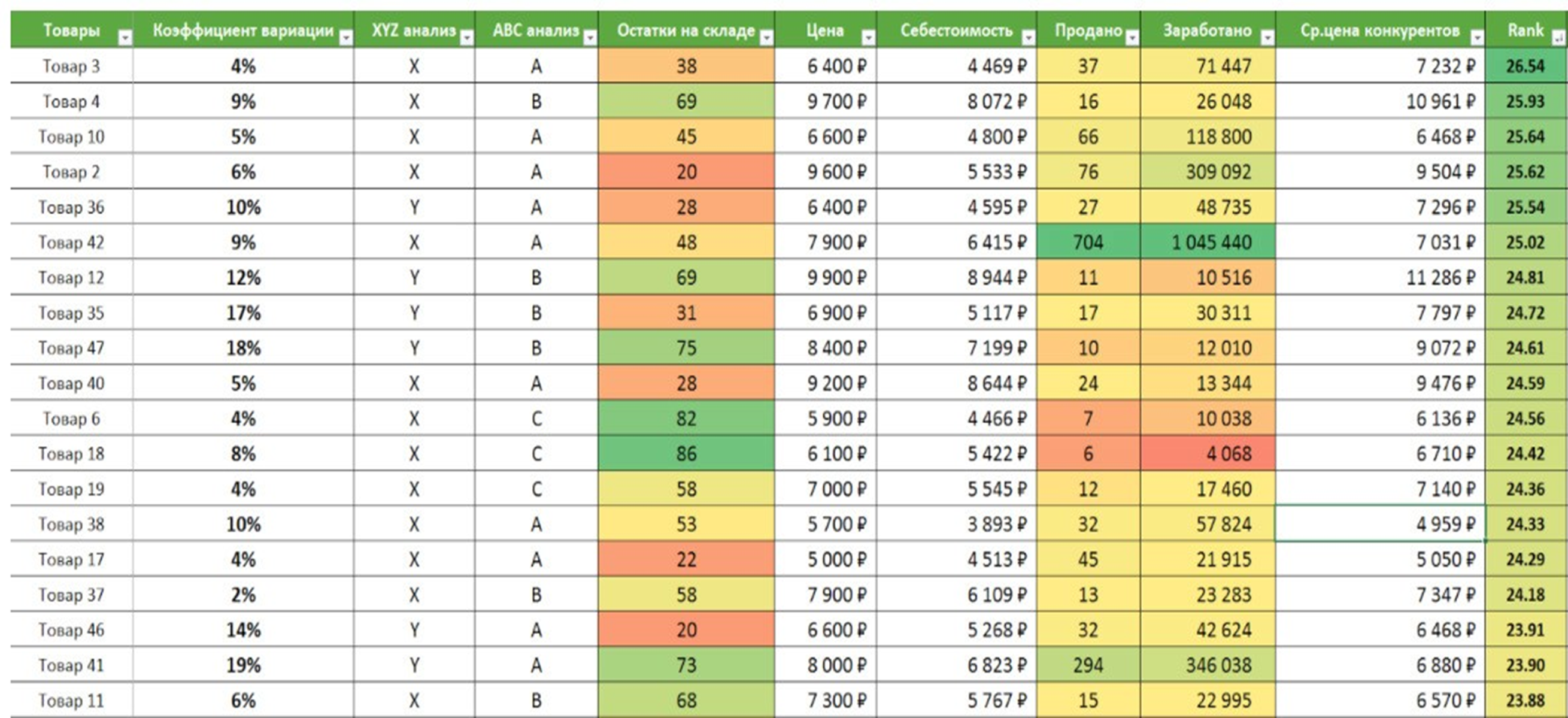

С помощью данной методики можно выбрать наиболее перспективные для продвижения запросы, причем эффективными они будут именно для бизнеса клиента, для которого конечная цель, конечно же, увеличение прибыли.

Для начала можно построить 3 отдельные таблицы с данными:

- Характеристика товаров. Сюда можно отнести себестоимость, цену в магазине, остатки на складах, цену у конкурентов, продажи за месяц, давность последней продажи, частота продаж и другое — многое из этого обычно есть в 1С. Можно пойти дальше и подключить более сложные характеристики товаров, например, различные виды анализов: ABC, XYZ, FMR, VEN и другие.

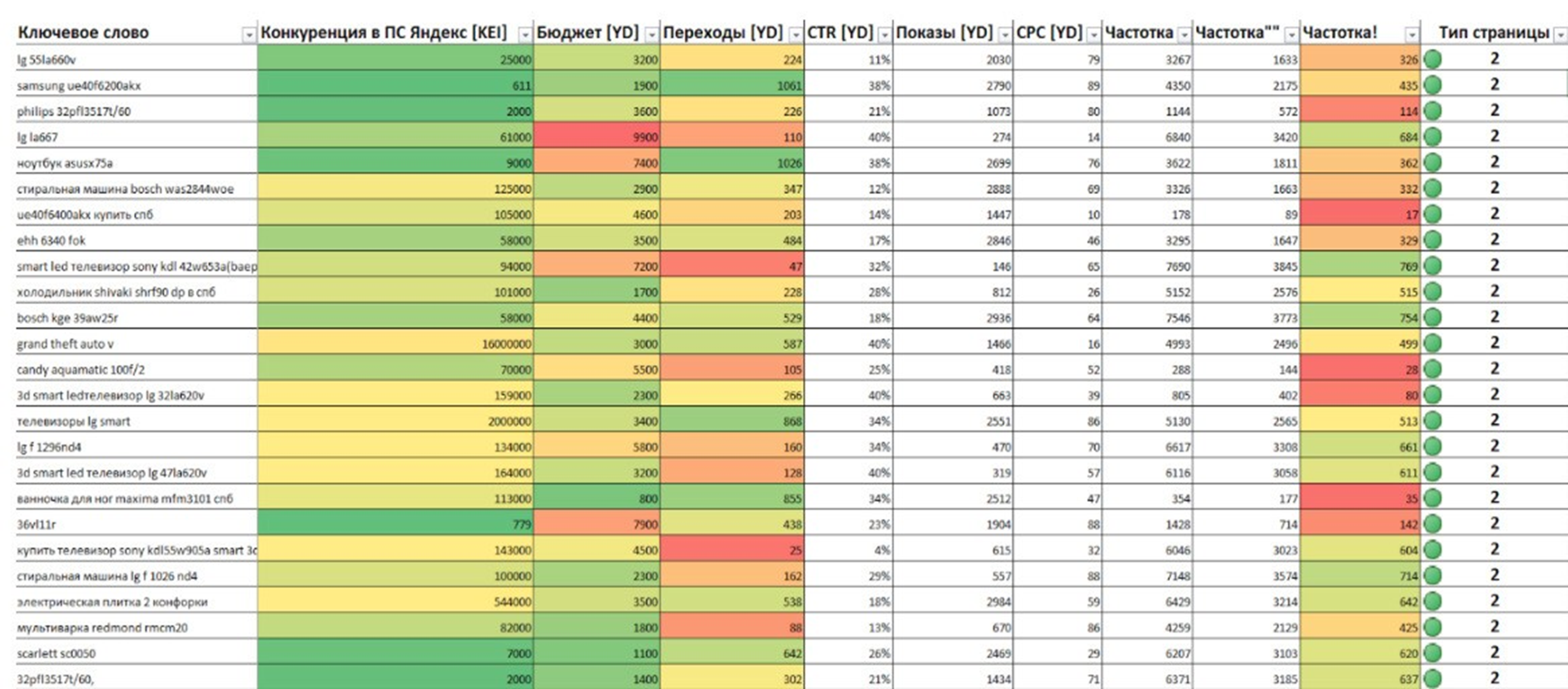

- Характеристика запросов. У запросов можно выделить частотность, сезонность, стоимость клика в Директе, позиция, бюджет на продвижение в ссылочных агрегаторах, количество документов в выдаче Яндекса, прогноз спроса, тип запроса (здесь пригодятся классификации из прошлого доклада) и многое другое.

- Характеристика страницы+запроса. Главное, что стоит учитывать при составлении этой таблицы — нельзя рассматривать страницу в отрыве от запроса. Да, на одну страницу обычно ведет несколько запросов, поэтому каждую такую пару стоит рассматривать отдельно. К их характеристикам можно отнести посещаемость, конверсию, время на странице, глубину просмотров, показатель отказов, демографию и географию пользователей, количество выходов со страницы и т.д.

Когда все данные собраны:

- Надо привязать пару запрос-документ к товару.

- Собрать одну большую таблицу.

- Почистить данные от пустот и мусора.

- Провести стандартизацию и нормализацию.

- Написать самую лучшую формулу ранжирования товаров.

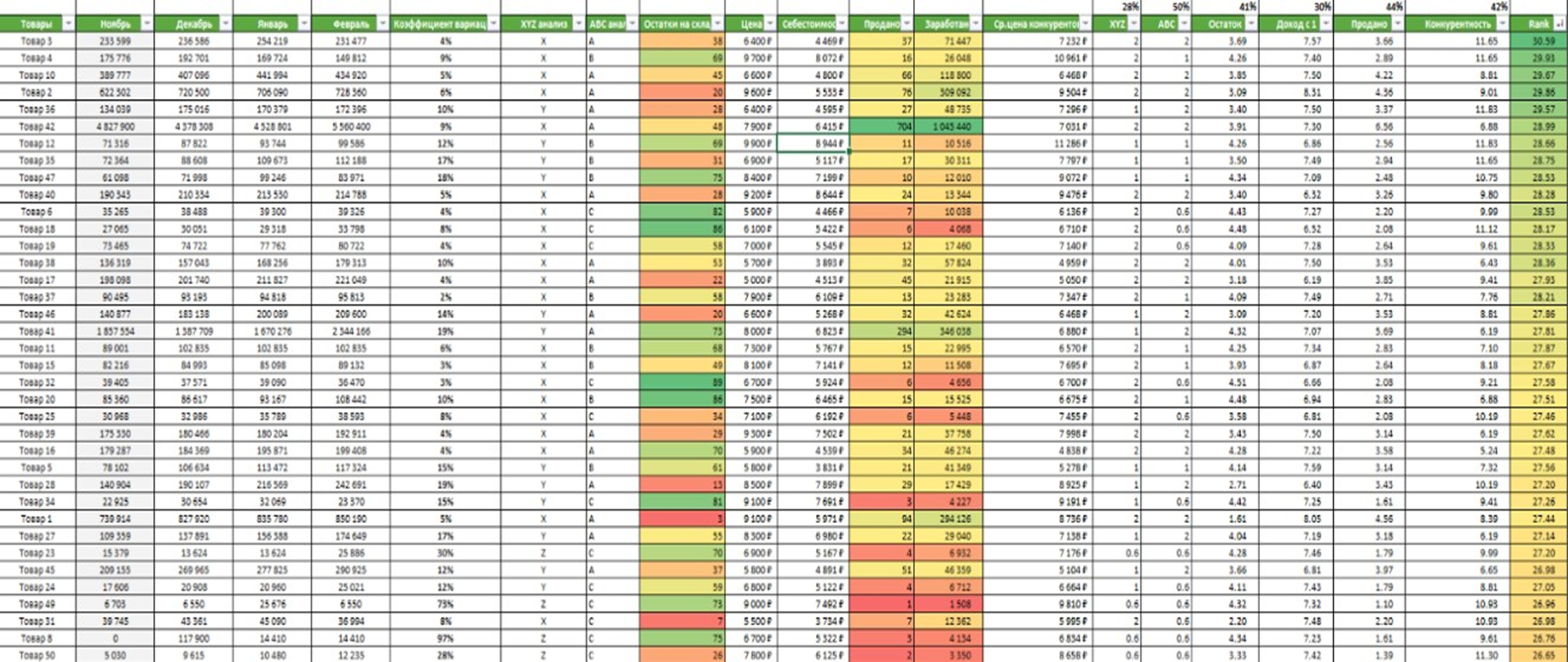

В итоге получится примерно следующее:

Что мы здесь видим? Множество чисел, которые, на первый взгляд, трудно сопоставить с чем-либо вообще. Но преимущества такой таблицы в том, что:

- итоговым значением любой формулы будет число;

- чем число больше, тем лучше оно удовлетворяет условию.

- отранжировав список товаров в порядке убывания, вы получите крутые товары вверху и так себе товары внизу;

- все итоговые значения нужно рассматривать как относительные.

Другими словами, мы знаем, что 30,59 больше, чем 25,18, и нам этого достаточно, чтобы сравнить прогнозируемую эффективность двух товаров.

И в заключение доклада — два скриншота c результатами применения данной методики:

В качестве итога

Технологии поисковых систем не стоят на месте, они все глубже анализируют сайты, пытаясь понять, какие из них наилучшим образом отвечают на вопросы пользователей и помогают в решении проблем. Необходимо больше внимания уделять коммерческим факторам ранжирования, которые распространяют свое влияние на сайт в целом, а не на отдельные страницы. Как уже говорилось выше, лучше всего следовать рекомендации Яндекса делать сайты для людей, создавая необходимый полезный функционал и представляя информацию в наиболее удобном виде, завоевывая доверие посетителей и накапливая лояльную аудиторию.

2 дня конференции были насыщены интересными докладами, мы постарались поделиться с вами наиболее полезными, рекомендации из которых вы можете использовать на своих проектах прямо здесь сейчас. А если возникнут какие-либо сложности — вы всегда можете обратиться в Ареал, и наши специалисты помогут в решении ваших задач в области интернет-маркетинга.